NAIST Robotics Laboratory

インタラクション動作の生成

人と人のインタラクションと同様に,人・ロボット間のインタラクションを考慮した際に,対話の実現は不可欠です.人型ロボットの場合,聴覚情報である音声対話の生成に加え,視覚情報であるボディジェスチャの生成も非常に重要になってきます.特に私たちは安全性などの面からロボットに人間に似た見た目を持つアンドロイドを用いています.このため,他のロボットと違い,さらに人間らしい動作生成が要求されます.

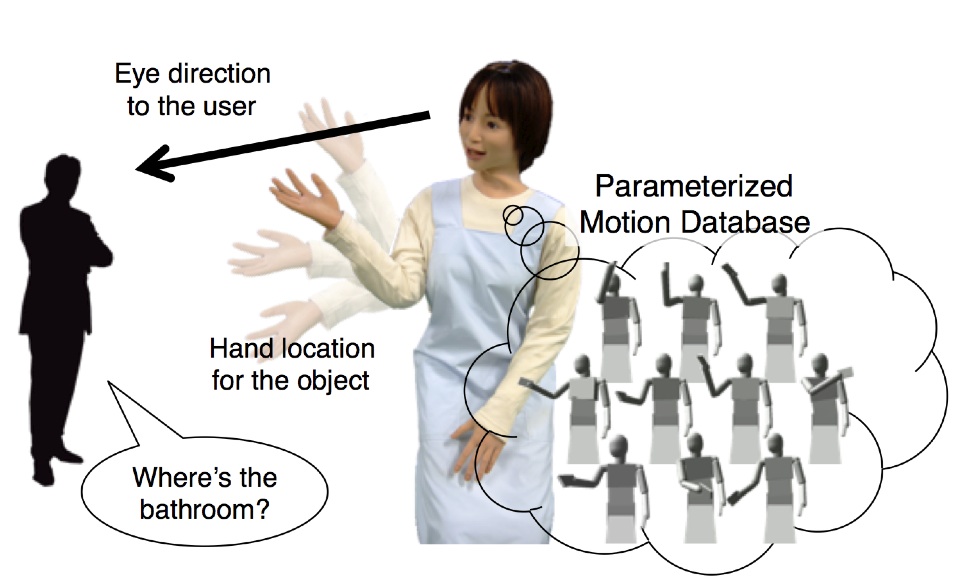

このボディジェスチャ生成に対して,私たちはこれまでに人間の動作データベースとオンラインプランニングを組み合わせた再構成可能な動作データベースを用いた動作生成手法を提案してきました.この手法には大きく分けて2つの特徴があります.

応答性の高い動作生成

オフラインの動作生成と違い,人との対話で必要となるジェスチャ動作の生成は高い応答性が必要となります.さらに,アクトロイドは人間らしい見た目を持つため動作においても人間らしい振る舞いが要求されます.

そこで,私たちはモーションキャプチャによって撮影された人間の動作をあらかじめ再構成可能な形でデータベース化し,それらをロボットの自己干渉なくスムーズに繋ぎあわせる手法を提案しました.これによりリアルタイム性と人間らしい動作生成を両立し,応答性の高いインタラクションを可能としました.

パラメータ合成による動作の最適化

真正面の話者に対して特定された対話を行うと仮定すると,各ボディジェスチャはそれぞれ一つの固定された動作シーケンスを再生するだけで済みます.しかし,実世界ではそういった仮定は成り立ちません.話者は移動し,対象物(指さしたい物体など)は環境によって異なります.そこで,動作データベース中にある類似動作を,話者の立ち位置や対象物の指示方向などをパラメータとして合成することでこの問題を解決します.

奈良先端科学技術大学院大学の情報科学研究科は,平城遷都1300年祭の会場で2010年10月2日〜15日にかけて各研究室が研究成果の展示を行いました(http://www.naist.jp/event/1300_j.html). その中で,私たちロボティクス講座は多人数との対話を実現するインタラクションシステムのデモを行いました.このデモで得られた知見から,人間に与えるロボットの印象や滞留時間を向上させることが確認できました.

主要関連論文

- 近藤 豊, 竹村 憲太郎, 高松 淳, 小笠原 司: データベースとオンラインプランニングを統合した高速応答可能なジェスチャ生成, 日本ロボット学会誌, Vol. 30, No. 9, pp. 899-906, 2012.

- Yutaka Kondo, Kentaro Takemura, Jun Takamatsu, and Tsukasa Ogasawara, “A Gesture-Centric Android System for Multi-Party Human-Robot Interaction,” Journal of Human-Robot Interaction, Vol. 2, No. 1, pp. 133-151, 2013.